hatGPTは、文章の作成や質問への回答、情報整理など、さまざまな目的で活用できるAIツールです。日常の調べものから業務支援まで幅広く利用されていますが、その便利さの一方で、入力された内容がAIの学習に使われる可能性があることに懸念を抱く人も少なくありません。特に、個人情報や機密情報が意図せず学習に利用されるリスクは、適切な対策が求められる重要な問題です。

この記事では、ChatGPTに自身のデータを学習させないための方法について、個人ユーザーと企業ユーザーの観点から詳しく解説します。プライバシーを守りながら、安全かつ効果的にChatGPTを使いこなすために、ぜひ参考にしてください。

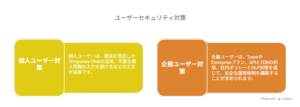

個人ユーザー向けの対策

学習のオプトアウト設定

ChatGPTの設定画面には「みんなのためにモデルを改善する」という項目があります。このトグルスイッチをオフにすると、入力した内容がAIの学習に使われなくなります。非常に簡単に設定できるため、まず確認しておきたい基本的な対策です。この設定はいつでも変更可能であり、自分の使い方に応じて柔軟に管理できます。

一時的チャットを利用する

Temporary Chat(テンポラリーチャット)機能を使うと、会話内容が保存されず、AIの学習にも使用されません。30日以内に自動削除されるため、機密性の高い会話に適しています。履歴も残らないため、情報管理の観点からも有効です。また、情報を一時的に相談したい場面や、個人情報を一切残したくないときにも安心して利用できます。

データ削除のリクエスト

過去に入力した内容が心配な場合は、「個人データ削除リクエスト」をOpenAIのプライバシーポータルから提出できます。この手続きによって、トレーニングデータからの除外を申請することが可能です。削除対象の特定や内容の明記が必要となるため、事前に会話履歴を整理しておくことをおすすめします。

アカウントの削除で完全な対応

すべてのデータを削除したい場合は、OpenAIアカウント自体を削除することが必要です。ただし、ChatGPT以外のサービス(DALL·EやAPIなど)も利用できなくなる点に留意してください。アカウントの削除手続きには一定の猶予期間が設けられており、その間に復元の申請を行わなければ、全データが完全に削除されます。

個人情報の入力は控える

設定を変更しても、セキュリティ目的で会話が社内スタッフにレビューされることがあります。氏名、住所、連絡先、金融情報などの個人情報は極力入力しないようにしましょう。 また、個人を特定できるような表現(職場、家族構成など)についても注意が必要です。

強固なセキュリティ設定

OpenAIのアカウントには、強力なパスワード設定と多要素認証(MFA)を有効化することが推奨されています。不正アクセスを防ぐことで、個人データの保護がより強化されます。

企業ユーザー向けの対策と推奨プラン

企業は、顧客情報や内部資料など機密性の高い情報を取り扱うため、より強固なデータ管理が必要です。以下に対策と特徴を比較表にまとめます。

| 項目 | Team/Enterpriseプラン | 無料・Plusプラン | API利用 |

|---|---|---|---|

| 学習利用 | デフォルトでオフ | オプトアウト必須 | 2023年3月以降オフ |

| データ保存 | 柔軟に設定可能 | 最大30日 | 最大30日/ZDR可 |

| セキュリティ | 暗号化、MFA、SSOなど | 最低限の保護 | 暗号化、ZDR対応可 |

| 管理機能 | 管理画面、ドメイン制限 | なし | 自社で対応要 |

ビジネス向け有料プランの導入

ChatGPT TeamおよびEnterpriseプランは、ユーザーデータがデフォルトで学習に使われないため、業務上の情報漏洩を防ぐ上で非常に有効です。加えて、ログ管理やSSO(シングルサインオン)、データ保持期間のカスタマイズも可能であり、コンプライアンスに配慮した環境構築が行えます。これにより、安心して社員全体にAI活用を広げられます。

APIとZDR機能の活用

OpenAI APIを利用する場合も、2023年3月以降はデフォルトで学習に使用されません。**ZDR(ゼロデータ保持)機能を利用すれば、サーバーに情報が一切残らない設定も可能です。**これは、金融や医療など特に機密性の高い業種にとって不可欠な対策です。エンドポイントによって利用可能かどうかが異なるため、事前に確認が必要です。

DLP対策とガイドライン整備

DLP(データ損失防止)ツールを導入し、従業員の誤入力や情報流出を防止する体制を構築しましょう。また、AI利用ルールを明文化し、定期的な研修で周知を徹底することも大切です。 ユーザーが何をしてはいけないのかを明確に示すことで、ヒューマンエラーによる情報漏洩を防げます。

アクセス制御と監査の強化

部署や職種によってAIの利用範囲を限定したり、特定の用途にだけ使用を許可することも可能です。加えて、利用状況を定期的にログで確認することで、不適切な利用やセキュリティリスクの早期発見が可能になります。

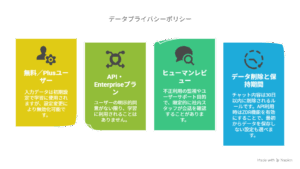

OpenAIのデータポリシーに関する最新情報

-

無料/Plusユーザー:入力データは初期設定で学習に使用されますが、設定変更により無効化可能です。

-

API・Enterpriseプラン:ユーザーの明示的同意がない限り、学習に利用されることはありません。

-

ヒューマンレビューの実施:不正利用の監視やユーザーサポート目的で、限定的に社内スタッフが会話を確認することがあります。全ての会話が自動で確認されるわけではなく、監査目的に限定されています。

-

データ削除と保持期間:チャット内容は30日以内に削除されるルールです。API利用時はZDR機能を有効にすることで、最初からデータを保存しない設定も選べます。

他のAIサービスとの比較

| 比較項目 | ChatGPT(個人) | ChatGPT(企業) | Google Gemini | Claude(商用) |

| 学習利用 | オン(オプトアウト可) | デフォルトでオフ | オン(設定で変更可) | オフ(明示的同意が必要) |

| データ保持 | 最大30日(削除可) | 柔軟設定可能 | 最大18ヶ月 | 最大30日 |

| ヒューマンレビュー | あり | あり | 品質向上目的であり | 限定的に実施 |

| 暗号化対応 | 転送・保存時対応 | 同左 | 転送時のみ対応 | 転送・保存時対応 |

他社のAIサービスでも、学習への利用やデータ保持の方針には違いがあります。特にGoogle Geminiはデフォルトで多くの情報を保持する一方、ChatGPTのビジネスプランやClaudeは、よりプライバシー重視の設計になっています。

まとめ:プライバシーを守りながらChatGPTを使う

ChatGPTは便利で強力なツールですが、プライバシー保護の視点を持って活用することが大切です。 AIの進化と共に、私たちのデータの扱い方も常にアップデートしていく必要があります。

-

個人ユーザーは、設定の見直しやTemporary Chatの活用、不要な個人情報の入力を避けるなどの工夫が重要です。

-

企業ユーザーは、TeamやEnterpriseプラン、APIとZDRの利用、社内ポリシーとDLP対策を通じて、安全な運用体制を構築することが求められます。

AI技術は進化し続けています。変化するデータポリシーや新機能の情報を常に確認し、リスクを抑えながら効果的に活用していきましょう。

コメント